苹果专利为ARkit提出MR远程通信技术,让视频通话更沉浸

2021-12-01

在名为“Environment for remote communication”的专利申请中,苹果描述了一种用于远程通信的技术。具体来说,这家公司介绍的发明可以通过用户通过智能手机或平板电脑来呈现混合现实影像,从而实现沉浸感高于普通视频对话的逼真远程通信。

在通信会话期间,设备可以在扩展现实环境中呈现远程参与者的虚拟表示,例如虚拟化身。扩展现实环境可以呈现给一个或多个本地参与者。在一个实施例中,至少部分地使用锚定装置的位置来确定虚拟表示的位置,例如,虚拟表示可以位于锚定装置之上。以这种的方式,本地参与者可以通过将锚定装置放置在任意期望位置。在一个实施例中,当锚定装置移动时,虚拟表示可以相应地移动,例如改变位置或旋转。

在一个实施例中,一种方法包括:第一电子设备的显示设备呈现扩展现实环境,第一电子设备同时接收呈现通信会话的远程参与者的虚拟表示的请求;响应于接收到呈现远程参与者的虚拟表示的请求,将第二电子设备定位在物理环境中的第一位置。当第二电子设备位于物理环境中的第一位置时,通过显示设备呈现远程参与者的虚拟表示,使得虚拟表示看似位于物理环境中的第二位置。其中,第二位置不同于第一位置,并且使用第一位置的第一坐标确定第二位置的第一坐标。

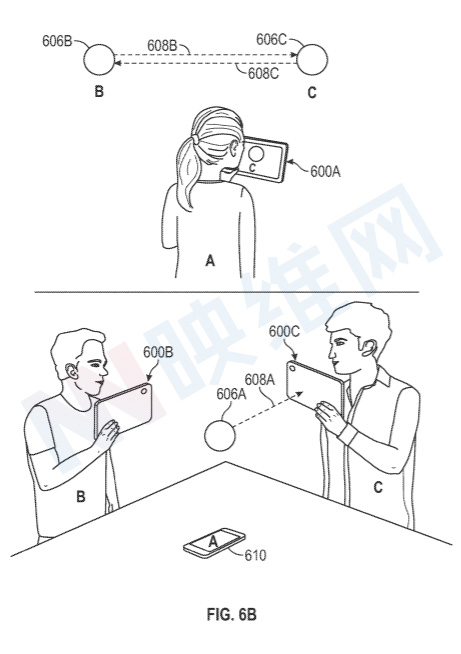

举个例子,两名本地参与者可以各自手持一台支持混合现实功能的智能手机,并把另一台支持全息投影且作为锚定装置的第三台设备摆放在桌面。这样,第三台设备可以远程参与者的虚拟化身,而两名本地参与者则可以通过各自的智能手机进行查看。如果你看过《星球大战》,你应该不会对这种全息通信感到陌生。

另外,在一个实施例中,虚拟表示的位置可以至少部分地使用本地参与者的设备位置来确定。例如,虚拟表示可以显示在与向本地用户设备相同的高度,以便在本地眼睛水平向来呈现虚拟表示。如果有多名本地参与者,虚拟表示可以显示在不同的高度。例如,虚拟表示可以显示在本地参与者使用的所有设备的平均高度,或者显示在最低设备的高度,这样用户就不必抬头查看虚拟表示。作为另一个示例,不同的设备基于各自设备的高度,并以不同的高度呈现虚拟表示,从而为每名参与者定制扩展现实环境。

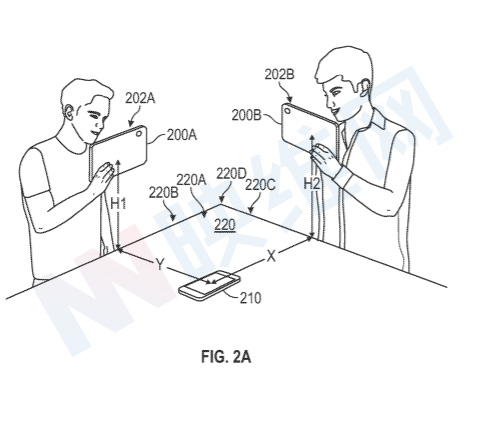

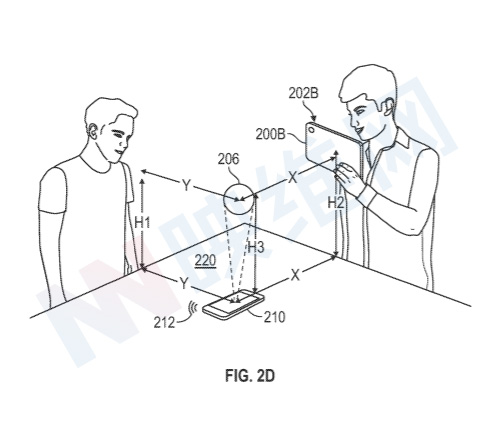

参考图2A-2D,其描述了用于为与远程参与者的通信会话提供XR环境的示例性技术。

图2A描绘了包括设备200A、设备200B、设备210和桌面220的物理环境。如图2A所示,设备200A和设备200B是由各自用户持有的平板电脑。在一个实施例中,设备200A和设备200B是智能手机或头戴式设备。在另一个实施例中,设备200A和设备200B可以是不同类型的设备,例如,设备200A可以是平板电脑,设备200B可以是头戴式设备。

设备200A和设备200B包括呈现XR环境的各自显示器202A和202B。设备200A和设备200B可以呈现公共XR环境,或至彼此不同的各自透视图。对于后一种情况,可以是共享XR环境的一定公共特征,但视图为自定义。

在一个实施例中,设备210与设备200A和/或设备200B通信,并称为“锚定装置”。桌面220为矩形,其表面220A建立任意笛卡尔参考框架。锚定装置210具有由坐标x和y定义的水平(x-y)位置,且高度(z坐标)为零(锚定装置210平放在桌面220之上);设备200A具有高度H1;设备200B具有高度H2。

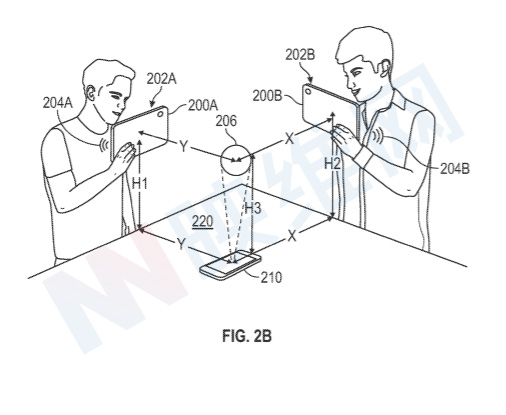

图2B中的示例性通信会话包括但不限于电话呼叫、会议呼叫和视频呼叫。在一个实施例中,锚定装置210、设备200A或设备200B发起设备200A、设备200B和远程参与者之间的通信会话。在一个实施例中,设备200A、设备200B和远程参与者可以各自加入或拒绝加入通信会话。

当通信会话启动时,设备200A和/或设备200B接收到呈现通信会话的远程参与者的虚拟表示的请求。响应于接收到呈现远程参与者的虚拟表示的请求,设备200A和/或设备200B定位锚装置210(其位于物理环境中的位置(X,Y,0))并呈现远程参与者的虚拟表示206。

可以使用锚定装置210的位置来确定虚拟表示206的位置。例如,可以使用锚定装置210的位置的至少一个坐标来确定虚拟表示206的位置的至少一个坐标。在图2B所示的实施例中,使用锚定装置210的水平位置来确定虚拟表示206的水平位置,并使得虚拟表示206看似位于锚定装置210的上方。例如,虚拟表示206具有与锚定装置210相同的x和y坐标,但高度H3不同。

在图2B所示的实施例中,虚拟表示206是非描述对象,例如球体)。远程参与者的虚拟表示可以是其他形状(例如三角形、星形、立方体),并且可以具有各种视觉特征(例如不同的颜色、发光效果、半透明性等)。在一个实施例中,虚拟表示206包括与远程参与者相关联的图像(例如二维或三维图像)。

在图2B所示的实施例中,设备200A和设备200B可以同时提供通信会话的音频输出。在一些实施例中,设备200A和/或设备200B可以提供3D或空间音频,使得声音仿佛是来自于虚拟表示一样。在一个实施例中,当从远程参与者或远程设备接收音频数据时,虚拟表示206提供视觉指示。例如,虚拟表示206可以改变颜色和/或大小,又或者是通过动画来指示远程参与者正在说话。

在通信会话期间,锚定装置210可以进一步显示具有关于通信会话信息的用户界面,例如通信会话的持续时间、远程参与者的名称、来自远程参与者的设备的视频等等。

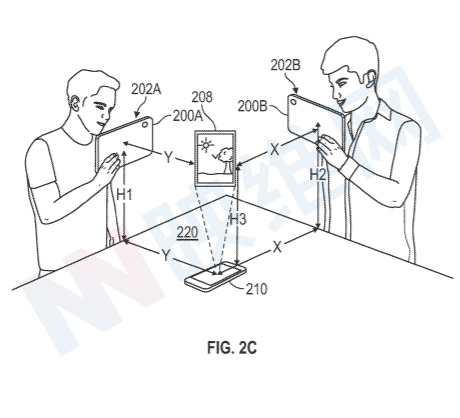

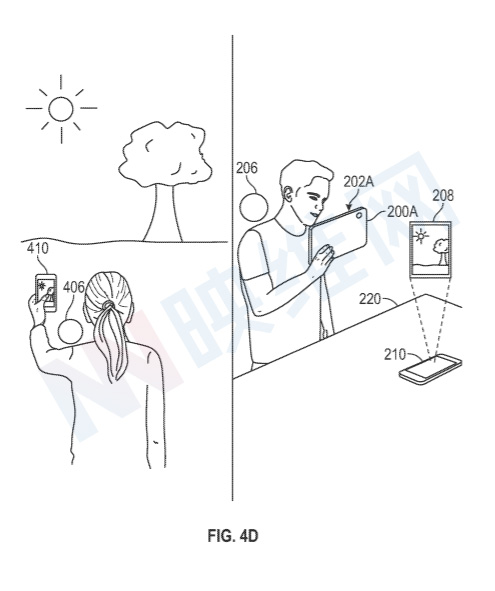

现在转向图4D,基于从通信会话的远程参与者接收的数据,可以定位虚拟表示206。从远程参与者接收的数据可以表示预定类型的内容(例如由远程参与者的设备摄像头捕获的图像)或远程参与者的设备的预定配置。

图4D的左侧是远程参与者的远程XR环境。远程参与者的XR环境包括远程参与者周围的物理环境,包括远程参与者正在使用的设备410,以及图中所示的本地参与者的虚拟表示406。在一个实施例中,虚拟表示406由远程参与者的另一设备呈现。如图4D的左侧所示,远程参与者举起设备410并使用摄像头来捕获远程参与者周围物理环境的图像。虚拟表示406位于远程参与者的肩膀上方。

图4D的右侧示是本地参与者的XR环境。在图4D右侧所示的实施例中,锚定装置210平放在桌面220之上,并且在锚定装置210上方呈现。在呈现虚拟表示208时,远程参与者的虚拟表示206呈现在本地参与者肩膀上方的位置,仿佛远程参与者正站在本地参与者的旁边,并看着虚拟表示208。这样,本地参与者和远程参与者的XR环境模拟参与者彼此并排放置的体验,共享远程参与者的物理环境的类似视图。

原文来自https://news.nweon.com/92045

VR头显真的需要到180Hz吗?

2020-05-13

前HTC CEO周永明发布了一体式VR头显Mova

2020-05-27

全球首次!圆周率科技5G+VR直播带你“云登顶”世界屋脊

2020-05-28

数字化虚拟景区:未来必然趋势

2020-05-15

iPad Pro:HoloLens 2第三人称视角的最佳解决方案

2020-05-13